IA sans supervision humaine : Le scandale Deloitte

Le scandale Deloitte Australie ébranle la confiance et dévoile les dangers de l’IA sans supervision humaine. En effet, en octobre 2025, Deloitte Australia a été contraint de rembourser partiellement 440 000 dollars australiens (290 000 USD) après la livraison d’un rapport gouvernemental truffé d’erreurs générées par l’IA.

Ce document de 237 pages, destiné à examiner les systèmes de conformité automatisés du ministère de l’Emploi et des Relations de Travail, contenait des citations de juges fictives, des références académiques inexistantes et des erreurs systématiques. L’enquête révéla que l’IA Azure OpenAI GPT-4o avait été utilisée sans supervision adéquate. En fait, cet outil a généré ce que les experts appellent des « hallucinations » i.e. des informations plausibles mais totalement inventées.

Ce scandale révèle trois vérités essentielles :

- premièrement, l’IA n’est pas une boussole infaillible mais un outil puissant nécessitant une gouvernance rigoureuse ;

- deuxièmement, la confiance aveugle dans la technologie peut conduire à des erreurs systémiques d’une ampleur démesurée ;

- troisièmement, l’expertise humaine reste irremplaçable pour valider, contextualiser et garantir l’intégrité des analyses.

Les pièges de l’IA sans supervision humaine

Quand la technologie devient source de risque

L’incident Deloitte sert ainsi de catalyseur pour une réflexion profonde sur l’équilibre entre automatisation et jugement professionnel dans l’audit moderne.

IA sans supervision humaine : L’illusion de l’automatisation totale

L’attrait de l’automatisation complète représente un piège dangereux dans le domaine de l’audit. Aussi, lorsque Deloitte a confié la rédaction d’un rapport critique à l’IA sans mécanismes de vérification humaine, ils ont démontré une croyance trompeuse.

Cette approche néglige un point essentiel : les systèmes d’IA générative sont avant tout des machines à créer du contenu plausible. De ce fait, elles ne sont pas conçues comme des outils de vérification factuelle.

Les conséquences de cette illusion sont multiples.

- Tout d’abord, l’IA peut générer des citations et références qui semblent parfaitement légitimes. En réalité, elles sont totalement fictives.

- Ensuite, elle peut manquer le contexte juridique et réglementaire crucial qui guide l’interprétation des données.

- Enfin, elle opère dans un vide éthique. Autrement dit, l’IA est incapable de comprendre les implications morales et sociales de ses analyses.

Comme l’a découvert Dr. Chris Rudge de l’Université de Sydney lors de l’analyse du rapport Deloitte :

I instantaneously knew it was either hallucinated by AI or the world’s best kept secret because I’d never heard of the book and it… » (source : The Associated Press)

Ainsi, le rapport Deloitte contenait des erreurs qui auraient été immédiatement détectées par un auditeur expérimenté. Cela démontre que l’absence de supervision humaine transforme l’IA. Par conséquent, c’est un outil puissant qui peut devenir une source potentielle de désinformation systémique.

IA sans supervision humaine : Les limites fondamentales des systèmes d’IA actuels

Les systèmes d’IA, aussi avancés soient-ils, présentent des limitations structurelles qui rendent leur utilisation sans supervision problématique en audit.

La première limitation réside dans le phénomène d’hallucination

les modèles de langage peuvent générer avec confiance des informations complètement inventées. Techniquement, il s’agit de la tendance à générer des informations factuellement incorrectes avec une haute confiance. En fait, c’est lorsque les patterns statistiques appris lors de l’entraînement ne correspondent pas à la réalité factuelle.

Comme l’explique la recherche du MIT (2024) : Les hallucinations résultent d’un déséquilibre entre la maximisation de la vraisemblance (produire du texte fluide) et la fidélité factuelle. Le modèle privilégie ce qui est statistiquement probable plutôt que ce qui est vrai.

Dans le contexte d’audit, c’est catastrophique : un modèle peut générer avec assurance une référence juridique inexistante ou une statistique financière erronée simplement parce que cela correspond aux patterns de langage observés dans ses données d’entraînement. Cette capacité à produire du contenu plausible mais factuellement incorrect représente un danger majeur dans un domaine où la précision est cruciale.

Deuxième limitation majeure : l’IA manque cruellement de compréhension contextuelle.

Elle traite les données comme de simples patterns statistiques. Aussi, l’IA est incapable de saisir leur véritable signification ou leurs implications juridiques.

Par exemple, elle peut identifier une anomalie comptable sans comprendre si elle résulte de :

- une erreur humaine,

- une fraude délibérée

- ou d’une particularité légitime du système comptable.

Cette absence de jugement contextuel rend les conclusions de l’IA potentiellement trompeuses si elles ne sont pas interprétées par un professionnel qualifié.

La troisième limitation touche à la responsabilité éthique et juridique.

L’IA ne peut pas :

- être tenue responsable de ses erreurs,

- témoigner en justice,

- faire face aux conséquences de ses recommandations.

Dans l’audit, la responsabilité professionnelle est fondamentale. C’est ce qui garantit la confiance du public dans le système financier. L’utilisation non supervisée de l’IA crée ainsi un vide de responsabilité qui mine les fondements mêmes de la profession d’auditeur.

De la leçon à la solution

Le scandale Deloitte nous offre une leçon douloureuse mais précieuse : l’IA sans supervision humaine est un risque, mais l’IA bien encadrée est une opportunité.

Les chiffres parlent d’eux-mêmes : Une recherche académique intitulée « How Does Artificial Intelligence Shape Audit Firms? » publiée dans Management Science (INFORMS, 2024) analyse l’impact de l’IA dans les cabinets d’audit, y compris chez Deloitte. Or cette étude présente des données quantitatives sur les gains de productivité.

En conséquence, cette perspective change tout. Plutôt que de rejeter la technologie, la réponse réside dans une collaboration intelligente où chaque acteur joue son rôle naturel. C’est exactement ce que démontre l’exemple des tests de substance (analyse exhaustive de toutes les transactions comptables, plutôt que d’un simple échantillon).

Ici, l’IA n’est pas un substitut à l’auditeur, mais son partenaire stratégique.

L’IA comme partenaire d’audit

L’exemple révolutionnaire des tests de substance

Le cabinet Deloitte a commis l’erreur de confier des décisions critiques à un outil IA sans supervision humaine. Par contraste, les tests de substance illustrent comment l’intelligence artificielle, correctement maîtrisée, devient un levier puissant pour amplifier l’expertise humaine.

Le défi traditionnel de l’analyse des écritures comptables

Traditionnellement, l’audit des écritures comptables (les enregistrements individuels des transactions financières) reposait sur des méthodes d’échantillonnage limitées et laborieuses. Les auditeurs devaient sélectionner manuellement un petit sous-ensemble d’écritures (souvent 50 à 100 transactions sur des milliers voire des millions) basé sur leur jugement professionnel et leur perception du risque.

Cette méthode d’échantillonnage restait la seule solution pratique. Pourtant, ses limites étaient fondamentales et bien réelles.

D’une part, cette méthode laissait une grande partie des données non examinées. Cela créait des zones d’ombre où pouvaient se dissimuler des fraudes sophistiquées ou des erreurs systémiques.

De l’autre, la sélection basée sur le jugement humain pouvait être biaisée. En effet, elle pouvait manquer des anomalies subtiles qui ne correspondaient pas aux patterns attendus.

Enfin, le processus était extrêmement chronophage, consommant des heures précieuses qui auraient pu être consacrées à l’analyse et à l’investigation.

Cette approche manuelle créait ainsi un compromis douloureux entre l’exhaustivité désirée et la faisabilité pratique.

L’IA comme détective financier : mécanismes techniques et résultats concrets

L’intervention de l’IA transforme radicalement cette dynamique grâce aux tests de substance avancés. Contrairement aux modèles génératifs (comme ceux impliqués dans le scandale Deloitte), les systèmes d’audit utilisent principalement l’apprentissage non supervisé. Ce sont des algorithmes qui apprennent les patterns normaux sans supervision humaine préalable.

Prenons quelques exemples :

- Isolation Forest : Un algorithme qui isole les anomalies plus rapidement que les points normaux. C’est comme un détective qui trie des dossiers suspects en quelques gestes.

- Autoencodeurs (réseaux de neurones) : Ces modèles apprennent à compresser puis à reconstruire les données normales. Les anomalies sont les données que le système ne parvient pas à reconstruire fidèlement.

- Analyse multi-dimensionnelle : L’IA examine simultanément des dizaines de caractéristiques (horaire, montant, historique fournisseur, libellé textuel) pour identifier des combinaisons subtiles d’anomalies.

Contrairement aux méthodes traditionnelles qui analysaient moins de 1% des transactions, l’IA examine désormais 100% des données du grand livre comptable (le registre central qui contient toutes les transactions financières d’une entreprise) en temps réel .

Le résultat est spectaculaire : Par exemple, l’IA améliore significativement l’efficacité du ciblage des fraudes fiscales par rapport aux méthodes traditionnelles.

Types d’anomalies détectées par l’IA :

- Horodatages suspects : Écritures passées en dehors des heures de bureau

- Montants « ronds » : Transactions juste en dessous des seuils d’approbation

- Fréquences anormales : Fournisseurs mineurs devenant soudainement majeurs

- Relations contreparties inhabituelles : Transactions entre entités sans lien opérationnel

- Descriptions atypiques : Utilisation de mots-clés étranges dans les libellés

Le processus collaboratif idéal fonctionne ainsi :

| Étape | Rôle de l’IA | Rôle de l’Auditeur |

|---|---|---|

| 1. Traitement | Ingère et nettoie l’ensemble des données brutes | Définit le périmètre et les sources de données |

| 2. Analyse | Produit une liste priorisée d’alertes (ex. : « Top 50 écritures les plus atypiques ») | Ne fait pas confiance aveuglément. Comprend la logique des alertes |

| 3. Investigation | Met en évidence les corrélations entre les données | Mène l’enquête, interroge le personnel, demande les pièces justificatives |

| 4. Conclusion | Fournit des recommandations basées sur les patterns détectés | Prend la décision finale, valide ou infirme l’alerte, documente son raisonnement |

Les garde-fous : Comment mettre en œuvre la validation humaine

La synergie homme-machine ne fonctionne que si des mécanismes de validation robustes sont en place.

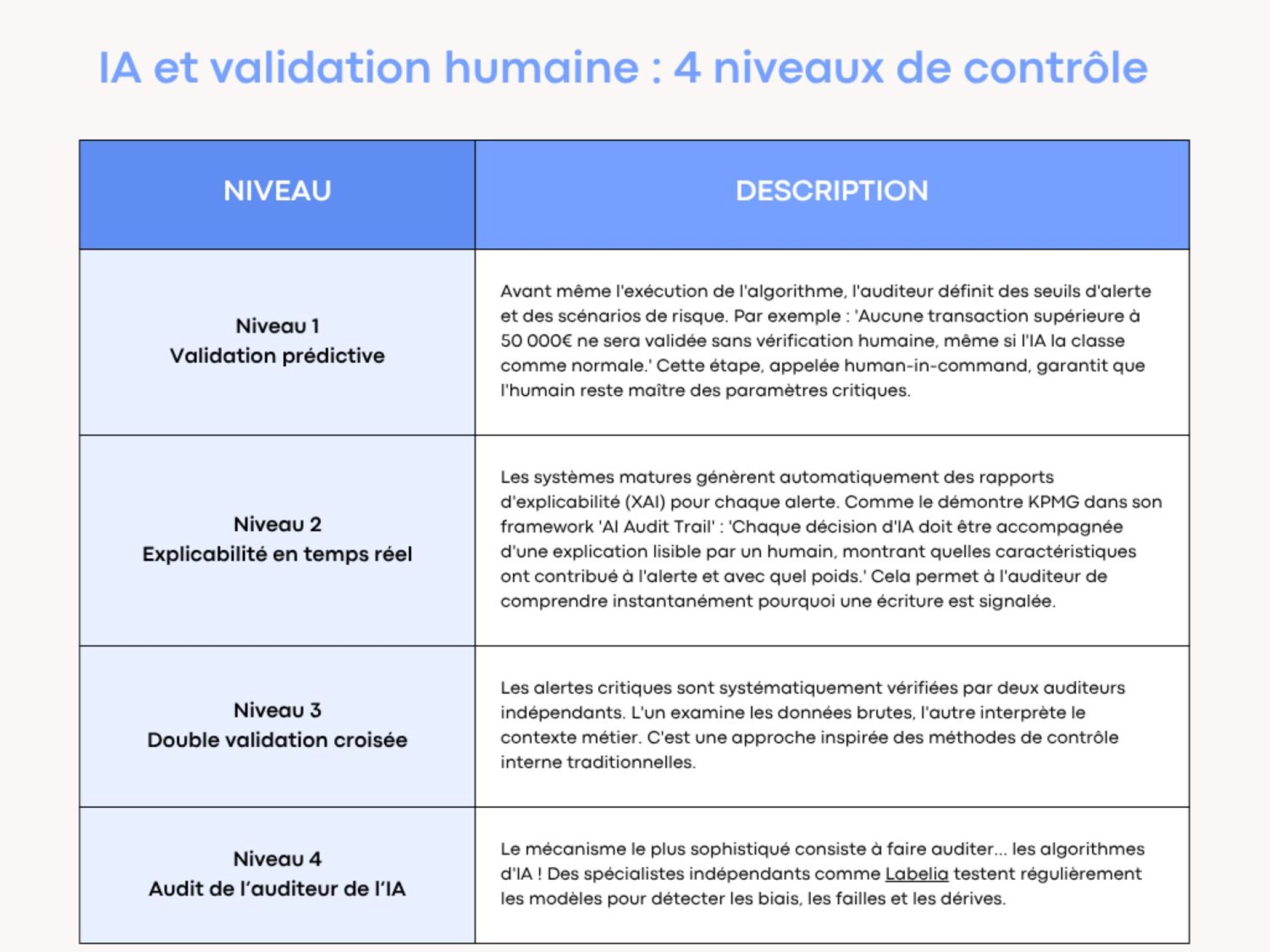

D’après les meilleures pratiques des Big 4, quatre niveaux de contrôle sont essentiels :

Le résultat : une synergie parfaite

En conséquence, les 4 niveaux de validation humaine constituent précisément la supervision qui a fait défaut chez Deloitte Australie.

L’auditeur ne passe plus des heures à chercher une aiguille dans une botte de foin. Il se concentre sur les points de risque les plus élevés, identifiés de manière objective par l’IA.

Son temps est alors réalloué vers des tâches à plus haute valeur ajoutée : l’investigation, l’entretien avec la direction, l’exercice d’un jugement éclairé. Par exemple, le cabinet EY, dans ses programmes anti-fraude à l’assurance a déclaré que 4% des dépenses totales de réclamations ont été économisées grâce à un programme anti-fraude optimisé.

IA sans supervision humaine : Nouvelle ère collaborative

Le scandale Deloitte n’est pas la fin de l’IA en audit, mais son vrai commencement. En fait, il marque le passage d’une ère d’illusion technologique à une ère de maturité professionnelle. Le message est clair et sans ambiguïté : l’IA ne remplace pas l’auditeur, elle le libère des tâches mécaniques.

Désormais, il peut se concentrer sur ce qui définit vraiment son métier :

- le jugement critique,

- l’investigation perspicace,

- et surtout, la responsabilité éthique face aux chiffres qui gouvernent nos économies.

Aussi, les tests de substance ne sont qu’un premier pas.

In fine, l’intelligence artificielle transforme profondément l’audit et la comptabilité en automatisant les tâches répétitives, améliorant la rapidité et la fiabilité des traitements. Désormais, elle permet d’analyser exhaustivement les données financières. En effet, l’IA détecte plus efficacement les anomalies et fraudes, tout en libérant les professionnels du chiffre pour des missions à plus forte valeur ajoutée comme l’analyse et le conseil.

Toutefois, en fin de compte, la supervision humaine reste indispensable pour garantir l’éthique, la qualité et la responsabilité des audits.